イベント

電気信号で手を自在に操る技術が登場。SIGGRAPH 2012「Emerging Technologies」展示セクションレポート(2)

「Emerging Technologies」展示セクションレポート(1)

PossessedHand

by 東京大学大学院情報学環 暦本研究室

〜フォースフィードバックから「火事場の馬鹿力」強制発動まで〜

Microsoftの「Kinect」に代表される「身体をコントローラ」として使うモーション入力システムは,ゲームやエンターテイメントにおいて,ユーザーのモーションをゲーム内キャラクターに投射できる,画期的で面白い仕組みである。ただ,1つ不満を挙げるならば,それは,フィードバックがないということだ。

ゲームパッドには最低限の振動フィードバックを備えているものが多いが,Kinectはハンズフリープレイングであるからこそ,フィードバックがないのも当たり前といえば当たり前。とはいえ,それでは少し寂しい。

たとえば,ゲーム内キャラクターが敵からの銃撃を受けてダメージモーションで倒れたとしよう。プレイヤーは,ゲーム内キャラクターが起き上がるのを待つしかないため,すぐにも反撃できる体勢のプレイヤーと,起き上がるまで体勢が整わないゲーム内キャラクターの振る舞いとのギャップがストレスを生むことになる。コアゲーマーであればあるほど,このギャップに違和感を感じるようで,ガンダムでたとえるならば「ガンダムが僕の動きについてこれない!」的なストレスを感じるようだ。

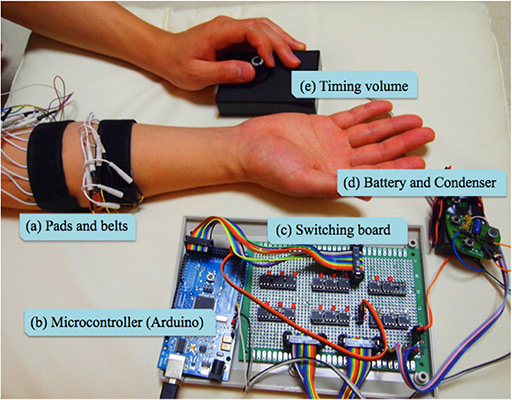

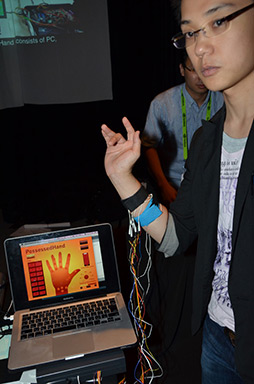

そんなストレスを解消してくれるかもしれないHCI(ヒューマン・コンピュータ・インタフェース)を発表していたのが東京大学大学院情報学環 暦本研究室だ。研究グループが発表したのは「PossessedHand」システムと呼ばれるもの。手首と肘の間に巻くバンドのような形状になっており,28個の電極が仕込まれている。

|

|

理科の授業で「電気刺激を与えるとカエルの足が動く」という実験をしたことがある人もいるかもしれないが,あれの高精度版と思ってもらえるといいだろう。ちなみに電気刺激は,電圧が17〜42V程度で,電流量が100mA程度とのことだ。

PossessedHandシステムを腕に付ければ,モーション入力ゲームにおいて,画面内のキャラクターがダメージを受けている間は身体の自由がきかないなどの一体感が味わえたり,敵からの攻撃を喰らって自然に手が開いてしまったり,といったことが表現できるようになるのだ。

|

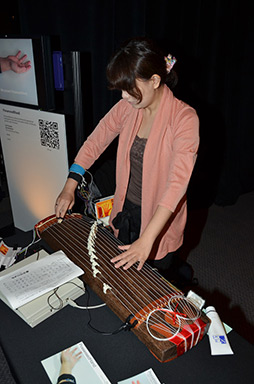

研究グループの担当者によれば,琴の演奏デモにおいて,PossessedHandシステムが制御しているのは今のところ指の動きのみで,腕の縦横の動きについては奏者が自分の意志で動かしているとのこと。腕全体の動きまでを制御するには,肩付近へ電極の装着が必要になるという。

電気刺激の強さやその与え方によっては,骨格や筋肉の破壊を伴うほどの“火事場の底力”を発動させることが可能だそう。それこそ腕全体を制御できるような電極装着は,周囲の人やあるいは自分自身に対してとてつもない力でパンチしてしまうことも考えられるため,今回は指の制御までの公開となっていたようだ。

なお,今回はSIGGRAPH 2012での発表ということで,ややエンターテインメント的な味付けがされていたが,本来は事故などによって身体麻痺を患っている人のための治療やリハビリなどが目的という。

|

Chilly Chair

by 電気通信大学 梶本研究室

「毛の逆立ち」で感動を増強させる

ゲームをプレイしていてそのストーリーやドラマの展開に感動してゾワワっと毛が逆立ってしまったという経験がある人は少なくないだろう。「バイオハザード」のようなホラーゲームをプレイしてい,てあまりの恐怖に毛が逆立ってしまったという人も多いはずだ。

このように人間の身体に生えている体毛の立毛現象は,感情が激しく揺り動かされたときに起こる身近な生理現象としてよく知られている。

「ならば,逆に,この『立毛』現象を強制的に誘発させれば,被験者の感情を増強させることができないか」という考えから開発されたのが,電気通信大学 梶本研究室の「Chilly Chair」システムである。

「恐怖や感動が毛が逆立たせる」からといって「毛が逆立たせることが恐怖や感動を生む」という解釈は半ば強引と思われるかもしれないが,あながちそうとも言い切れない。有名なのは,19世紀の心理学者が提唱したジェームズ・ランゲ説(James-Lange theory)である。この説を説明するのによく用いられるのが,「人間は悲しいから泣く」だけでなく「泣くと悲しくなる」ことがあるというものだ。

さて,研究グループが開発したChilly Chairは,その名のとおり椅子である。特殊なのは,そこに座った被験者の両腕を覆うようにカバーが被せられる点である。

体験中の様子。両腕のアタッチメントが静電気を発生させる立毛装置 |

静電気発生装置の裏側 |

|

ブースでは,被験者を驚かせる映像を被験者を驚かせるような映像を見せ,その驚かせ演出の瞬間に被験者を立毛させるデモが行われており,筆者も体験してみたが,立毛させられる瞬間はサワサワっとした感触が感じられ,無風状態にもかかわらず風を感じるような錯覚を覚えた。

今のところ,両腕が自由にならないので,コントローラを持ってプレイするゲームとの相性はあまりよくないかもしれないが,いっそ椅子だけでなく,腕を自由にさせたうえで部屋全体に静電気を起こして頭髪まで逆立たせてみるのも面白いかもしれない。あるいはこの機構をジョイパッドに仕込むことができれば,ゲームプレイの演出として「振動」以外に「立毛」の演出が加えられることになるだろう。

|

TELESAR V: TELExistence Surrogate Anthropomorphic Robot

by 慶應義塾大学・大学院メディアデザイン研究科・舘研究室

原発での作業活動も視野に入れたテレイグジスタンス技術

テレイグジスタンス(Telexistence:遠隔臨場感)というバーチャルリアリティ技術の応用分野がある。これは,ユーザーが今いるその場所で,遠方にいる相手と交流したり,遠方の現場で作業したりすることを実現する技術だ。

慶應義塾大学・大学院メディアデザイン研究科・舘研究室の研究グループはテレイグジスタンスの分野の研究を継続的に行っており,そのプロジェクトにはTELESARという名前を付けている。TELESARとは,「TELExistence Surrogate Anthropomorphic Robot」の頭文字を取ったもの。今回発表されたものは5世代めということで「TELESAR V」と名付けられている。

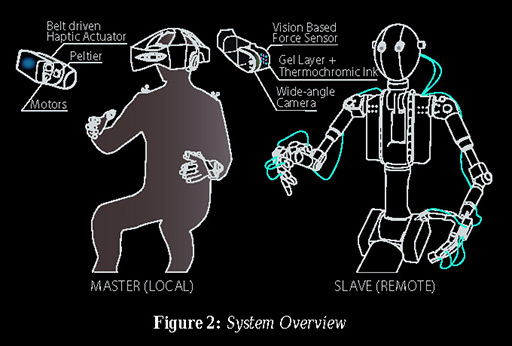

|

TELESAR Vは,人間が操作する「マスター・ユニット」と,遠隔地に設置した「スレーブ・ロボット」で構成されており,人間の動きをトレースする形でスレーブ・ロボットが稼動し,スレーブロボットの触感,視覚,聴感がマスター側の人間にフィードバックされる仕組みになっている。

マスター側の人間が装着するヘッドマウントディスプレイ(以下,HMD)は,スレーブ・ロボットに仕込まれた二眼式カメラからの視界を立体的に表示し,水平60°,垂直40°程度の画角の視界が1280×800ドットで再現される。担当者によれば,プロジェクト方式ではなく直視型の液晶ディスプレイが搭載されているため,HMDは意外に軽いのだとか。

そして,マスター側の人間が装着するグローブのようなものには,光ファイバーが仕込まれた指先曲げセンサーが仕込まれており,人間側の正確な指の動きをスレーブ・ロボットに伝えることができるようになっている。グローブの指先には,小型モーターでベルトを巻き上げて触感を伝える触感再現装置や,温度を再現するペルチェ素子が取り付けられており,スレーブ・ロボットが指先で触れた触感や温度をマスター側の人間に伝えることができるそうだ。

さらに,マスター側の人間の頭部や腕の動きは,ゲーム開発や映画制作に用いられるものと同じ,NaturalPoint社の光学式のリアルタイムモーションキャプチャーシステムによって取得されている。

マスター・スレーブ間の更新レートは60Hzだそうで,操作遅延時間は20ms〜30ms程度。ほぼリアルタイムに近い操作が可能だという。

|

現在のところ,テレイグジスタンスに特化した研究なのでTELESAR V自身に脚部はなく,移動手段は車輪だろうが,キャタピラ走行でも多脚歩行でもなんでもいいというスタンスだ。

応用分野としては,人間の出入りが著しく制限される作業現場,たとえばクリーンルームの工場や原子力発電所などが想定されている。20年後にはこうしたテレエグジスタンス技術ベースの原発内作業が現実的になるのではないか,と研究グループは予想していた。

ClaytricSurface:An Interactive Surface with Dynamic Softness Control Capability

by 電気通信大学大学院情報システム学研究科・情報メディアシステム学専攻・小池研究室

実際に手で3D形状を触って作り出せる3Dモデリングディスプレイ

8bit時代,少ない色数で低い解像度で美しい映像を作り出すアーティストをドット職人と呼んだものだ。現在では,3Dモデリングツールを使って自在に3Dモデルをモデリングできるアーティスト達をポリゴン職人と呼んだりする。

しかし,そういった卓越した技術を持つ彼らも,液晶画面内でのモデリングは,これまでその手法しかなかったからツールを使う技術が洗練されただけではないだろうか。究極的には,粘土細工のように,指で触れながら立体的にモデリングする手法のほうがいいとは思っていないだろうか。

そんなテーマに挑んだ研究が電気通信大学大学院情報システム学研究科・情報メディアシステム学専攻・小池研究室の「ClaytricSurface:An Interactive Surface with Dynamic Softness Control Capability」(以下,ClaytricSurface)だ。

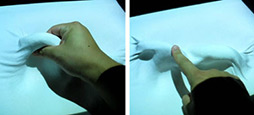

ClaytricSurfaceは,視覚的に「立体」を再現するのではなく,物理的に「立体」を表示することができるディスプレイ装置である。さらに,表示されている立体物に対し,手を加えて変形させることも可能だという。

|

モデリングできるのは立体物で,レリーフのような凹凸のみによるジオメトリに限定されるが,ブースのデモでも披露されていたが,人間の顔面の造形程度なら十分に作り込みが行えそうだ。

ひとたびモデリングが完了したら,その凹凸状態を固定化することができ,一度固定化すれば,しっかりとその形で固まり,指で押しても表面は変形しない。

形状を固定化したあとは,そのモデリングした凹凸面に対し,好みに応じて色を塗ることも可能。つまり,テクスチャマップのデザインが行える。

固定化した表面が不要になれば,初期化操作をすることで瞬間的に表面を柔らかくすることができ,手でなでるだけで平らにできるのだ。

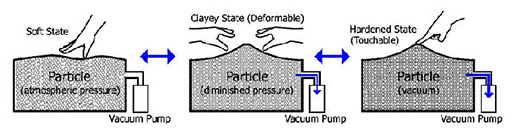

このように,ClaytricSurfaceでは,作業面の堅さを動的に変えられるのが大きな特徴といえるだろう。

作り出した凹凸は崩れず固定化できる |

ClaytricSurfaceのシステム概念図 |

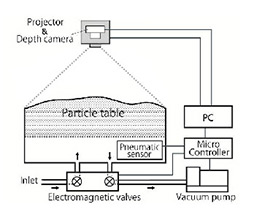

まず,凹凸面を覆っているのは気密性のある布で,その下には無数の微細な発泡ポリスチレン性のビーズがぎっしりと詰まっている。「枕のような触感」と感じたのはこの構造からだ。

では,どうやって表示面を固定化したり,あるいはゆるゆるの柔らか面にしているのか。実は,下部に電磁バルブとエアポンプが仕込まれており,内部の空気量を調節しているのだ。発泡ビーズ層が適度に空気を含んでいるときは柔らかく,空気を抜ききったときには硬く固定化されることになる。内部の空気量を変えることで動的に柔らかさ変化させていたのだ。

|

|

今のところ,作り込んだ凹凸面をセーブする仕組みや,作業途中だった凹凸モデルをロードして表示面に呼び出すような操作系は実装されていない。凹凸面をジオメトリモデルとして保存する(取り込む)ことはKinectセンサーを用いればできるだろうが,読み込んだ立体物データの形状で発砲ビーズに凹凸を再形成させる仕組みをどのように再現するかの目処がまだ立っていないという。

まだ課題は多そうだが,デジタル3Dとアナログ3Dを直結させるインタラクティブ技術として,今後の発展に注目したい研究だ。

|

|

|

|

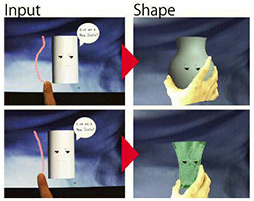

Magic Pot: Interactive Metamorphosis of the Perceived Shape

by 東京大学 大学院情報理工学系研究科・廣瀬・谷川研究室

〜“触覚”を“視覚”で“錯覚”させる「ダマシ」のテクニック

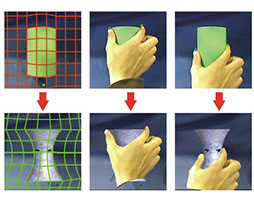

「人間の触覚は優れた精度を持っている」……確かにそのとおりなのだが,実は脳内での形状認識は,触覚だけでなく視覚も大きな役割を果たしている。

通常,こうしたテーマを学術的に研究するとなれば,提示された立体物の形状を目隠ししたまま触らせ,どんな形状かを描いてもらうというようなアプローチになりそうなものである。しかし,東京大学 大学院情報理工学系研究科・廣瀬・谷川研究室が発表した「MagicPot」は,あえて偽の視覚情報を与えられると人間の触感はいかにいい加減なものになってしまうかということをユーモアたっぷりに証明してくれるものになっていた。

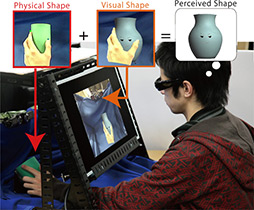

MagicPotでは,被験者がディスプレイ部の下に設けられた開口部へ腕を突っ込み,ディスプレイ部の背後にある小型のツボを触ることになる。開口部に突っ込んだ被験者の腕は,リアルタイムでディスプレイに表示されるので,直視はできないものの,ツボに向けて腕を伸ばしていく様が見て取れる。そうして,ディスプレイには,曲線美が美しい「くびれているツボ」をなで回す様子が映し出されることになる。

|

「はい。確かにくびれているツボですね。それが,何か?」と,たいていの被験者はキョトンとした顔になる。そして,「え? これでおしまい?」となるが,その時点でMagic Potの術中にハマってしまっているのだ。どういうことかというと,ディスプレイ裏側に置かれていたのは,くびれているツボではなく,茶筒のような円筒形のオブジェクトなのである。

被験者は騙されていたことに気が付き,頭で納得できても,「確かに自分は,指でなでたときに『くびれ』を感じた」と,首をかしげるのだ。

種明かしはこうだ。

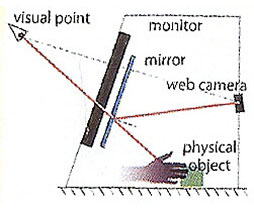

まず,被験者の手は,ディスプレイ裏側の奥に設置されたカメラでハーフミラー越しに撮影されている。ハーフミラーを用いているのは,ディスプレイに表示する実験エリアの撮影映像を被験者の視点に位置させる工夫だ。そして,ディスプレイ裏側には,円筒形のオブジェクトが設置されていて,これもハーフミラー越しに撮影されている。

このままだと,ディスプレイの裏側をただライブ中継しているにすぎないので,映像から円筒形のオブジェクトを画像処理で消し去りつつ,ほぼ同サイズのくびれたツボを同じ位置にCGで合成してやるのだ。

さらに,被験者の手が円筒形のオブジェクトに触れたときに,不整合が生じないよう「被験者の手」を「くびれたCGツボ」に触っているように変形して合成しているとのこと。

|

|

CGによるリアルタイムポストエフェクト処理によって被験者の手を加工している |

MagicPotのシステム概念図 |

このMagicPotでは視覚情報が支配的な情報となり,触覚が視覚情報の補足となっていることを意味する。今回のデモでは,エンターテインメント的な要素を強く打ち出していたが,人間の触覚の特性や曖昧さを理解することは,その先にあるユニークなマン・インタフェースの開発につながるはずだ。この先の展開も楽しみな研究だといえよう。

|

|

「Emerging Technologies」展示セクションレポート(1)

- この記事のURL: