イベント

顔面タブレットやVRガリバートンネル体験から空中結像ディスプレイまで。SIGGRAPH ASIA 2015,Emerging Technologies展示セクションその他編

|

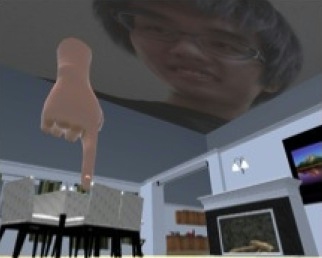

テレプレゼンスの未来形?

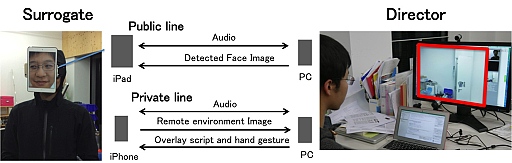

ChameleonMask: A Human-Surrogate System with a Telepresence Face

音声(Phono:ギリシャ語)を遠隔地へ飛ばすのが電話(Tele-Phone)なのは改めて説明する必要もないだろう。SIGGRAPHで発表される新技術の定番研究テーマには,存在感(Presence:英語)を遠隔地にも伝える技術をテレプレゼンス(Telepresence)技術がある。

東京大学大学院情報学環の暦本研究室が発表した「ChameleonMask」は,シンプルかつ斬新で分かりやすいテレプレゼンス技術の実現手法だ。

遠隔地の人同士が相手の存在感を感じながらコミュニケーションを行う,最も基本的なテレプレゼンスのスタイルはテレビ会議(ビデオチャット)ということになるわけだが,遠隔地に身体としての存在感を与えたいときや,遠隔地での物理移動,物理的なアクションを伴った作業活動までを実現しようとすると,これまでは遠隔地に置いたロボットを遠隔操作する……という極めて高度でハイコストな技術を駆使する必要があった。それはそれで素晴らしい研究なのだが,そうしたハイコストな技術は一般プレイヤーが使えるようになるまで時間が掛かってしまう。

そこで研究グループは発想を変え,遠く離れた目的地には別の人(代理人)に実際に行ってもらい,そこで送信者(遠隔プレイヤー)のニーズや要望に合わせて身体を動かしてもらう,という大胆な手法を提案したのである。

それが今回展示されていた「ChamelonMask」システム(関連URL)だ。

システムはとてもシンプルだ。

代理人は,その画面に遠隔プレイヤーの顔面を表示したタブレット(展示システムではiPadを採用)を顔前に付けることになる。この顔面映像は,遠隔プレイヤーの顔面をリアルタイムに捉えた映像である。

代理人は,遠隔プレイヤーのニーズに応えながら,身振り手振りを動かしたりすることになる。表情や音声は,遠隔プレイヤーを撮影している映像/音声をそのままタブレットで再生するだけだ。なお,周りにいる人には聞こえないように代理人に細かい演技指導や,行動指示を伝えるためのプライベートラインも用意されている。

|

|

代理人は完全に黒子(くろこ)となり,遠隔プレイヤーの操り人形に徹することになるわけだが,眼前にタブレットを取り付けると視界が塞がれるため,前がまったく見えなくなって危なっかしい。

そこで,ChamelonMaskでは,タブレットを直接顔に付けるのではなく,タブレットをVR-HMDに括り付けたような構造を採用している。代理人は,周囲の情景をこのVR-HMDで視認することになるわけだ。

ちなみに,展示システムのVR-HMDは,ハコスコと呼ばれるスマートフォンを括り付けてVR-HMD化するGearVRのようなタイプのものを採用していた(使用されていたのはハコスコDX)。今回の展示システムでは,カメラはスマホ側の内蔵カメラを用いていたが,タブレット側の内蔵カメラを用いることも技術的には問題ないはずである。いずれにせよ,仰々しいカメラを付ける必要はなく,この点もシンプルである。

|

実際に筆者も,女子大生の代理人に扮してみたのだが,道行く人が指を指して笑ってくれるのでなんだ楽しくなってしまった。手軽に変身願望が叶えられるという点でも面白いかもしれない。

|

実際の活用事例としては,外に出られない病人や老人のお使い代行といったマジメな用途から,アイドルの出張サービス,新しいスタイルのコスプレといったエンターテインメント用途なども挙げられており,応用範囲はアイデア次第で広がりそうである。

|

|

現状ではこのようなシステムの構築にハコスコ内のスマートフォンとタブレットという2つのスマートデバイスが必要になっているのだが,将来的には,かつてのガラケーのセカンドスクリーンのように,そうしたVR-HMDやAR-HUDの対外面側にセカンドディスプレイが付くこともありえなくはない。そうなったとき,このChamelonMaskの技術は定番コミュニケーションアプリとして未来のVR/ARプレイヤーに定着しているかもしれない。

新着想のウェアラブルの操作系

SkinWatch: Adapting Skin as a Gesture Surface

IoT(Internet of Things)時代の到来などと騒がれ,スマートウォッチなども続々と製品化されて,昨今,なにかとウェアラブルガジェットが盛り上がりを見せている。

そこで課題となり続けているのが,そのユーザーインタフェース(UI)だ。

ウェラブルガジェットは,機器としての筐体サイズが小さいため,必然的に画面も小さくなる。操作ボタンの設置も限定的だ。腕時計型のガジェットには竜頭(りゅうず)型のボタンが付いていることもあるが,そうしたボタンだけではなかなか高度な操作は難しい。かといってなにからなにまでタッチパネルにすればいいかというと,そういう単純な話でもない。というのも,そもそ小さい画面ではタッチ操作がしにくく,タッチ操作中の指で操作画面の表示変化が見えなくなってしまい,なにかと都合が悪いのだ。

画面を隠さないで自在な操作はできないものか。そんな要望に答えてくれるそうな技術が,慶應義塾大学情報工学科の今井研究室が開発した「SkinWatch」という技術だ。

SkinWatchシステムは,腕時計型ガジェットの操作システムとして考案された技術で,ガジェットをはめている腕の皮膚をひっぱたり,ねじったりして操作する。

例えば,拡大はタッチパネルのピンチアウト操作のように皮膚を親指と人差し指を押し広げるような操作をすればいい。縮小は逆にピンチイン操作のように皮膚を親指と人差し指をつまむように操作する。回転は,皮膚を親指と人差し指で互い違いにネジればいい。普段,タッチパネルでやっているような操作を,ガジェットを挟んで皮膚の上でやればいいのだ。

|

|

10個の測距センサーが検知した皮膚の距離分布の変化から皮膚のたわませ方やひっぱり方を検出し,そこから指の動きを認識して,操作コマンドに変換する仕組みだ。筆頭研究者の尾形正泰氏によれば,現在のシステムでは14パターンの指の動きを検出することができているとのこと。

検出しているのは皮膚の動きなので,操作する際に皮膚を露出せずに,衣服の上からも操作でき,手袋を付けた手でも操作できるだろう。「皮膚を触る」という直接的な操作系なので,操作していることの実感(触感)が得られるのもタッチパネル操作や中空ジェスチャー操作にはない特性だといえる。

|

バーチャルガリバートンネル体験!?

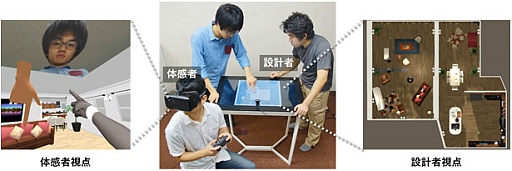

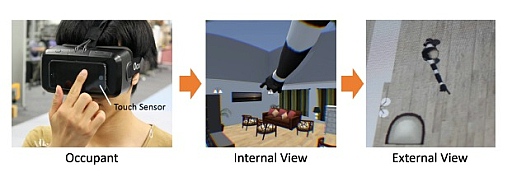

Dollhouse VR: A Multi-view, Multi-user Collaborative Design Workspace with VR Technology

ドラえもんの定番ひみつ道具に「ガリバートンネル」というのがある。これは,大きな入口から入って小さな出口から出ると自分の身体が小さくなって,狭い場所も広く使えてしまうというものだった(逆順経路では大きくなる)。それこそ,小さくなった被験者からすれば,人形のおうち(Dollhouse)でも,人間サイズの家として使えてしまう。

そんなガリバートンネル体験をバーチャルに実現してしまったのが産業技術総合研究所,東京大学 情報理工学系研究科 コンピュータ科学専攻 五十嵐研究室が開発した「Dollhouse VR」だ。

このDollhouse VR,実は遊び用途のものではなく,住宅建築などにおける空間レイアウト設計への活用を想定した産業向けの「マジメ」なシステムだったりする。とはいえ,体験としてはとても楽しいので,マジメな設計ツールとしても,エンターテインメント用途としても利用できる応用範囲の広い技術だと言える。

|

住宅を設計し,あるいは設計した家屋に家具などをレイアウトする際など,一度,その家屋内をコンピュータ上でCGとして再現して,住人視点でそのバーチャル家屋内をマウスやキーボードで歩き回って景観や使い勝手を検証する……というのは,一部の大手建築会社や住宅販売会社ではすでに始めているサービスである。こうした「家屋内バーチャルウォークスルー」で問題なのは,住人視点で見て気に入らなかったときに,一度図面に立ち返って修正し,再びCGモデルを生成し直して,再度,体験し直さなければならない点だ。

この「屋内レイアウトの変更←→住人視点の検証」の作業が,同時に行えれば,面倒な作業の反復往復を低減回避できるはずである。そしてさらに,その「家屋内バーチャルウォークスルー」が最先端のVR-HMDで行えたら,住人視点の検証もリアリティが増すはずだ。こうした着想のもとに開発されたのがDollhouse VRなのである。

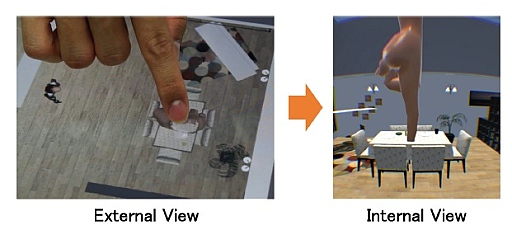

まず,家屋内のレイアウト設計は,上部から見下ろした視点の設計図面的な2D画面で行う。この設計図面は,タッチ操作対応の液晶モニターに表示されており,パレットのようなところから新規の家具を家屋内に配置したり,一度置いた家具の配置を変えたりすることができる。

|

|

2D設計図面上での作業結果は,屋内の3Dレイアウトとしてリアルタイムに3DCG化されて反映される。住人視点のプレイヤーは,VR-HMDを被り,この3DCG化された屋内を,ゲームパッド操作で歩き回ることができ,頭部を動かすことでバーチャル家屋内を自由に見回すことも可能。

ここで,もし,住人視点プレイヤーが,家具類のレイアウトが気に入らない場合はどうすればいいのか。

|

住人視点プレイヤーは,ゲームパッド操作で任意の箇所を指差しすることができるので,気に入らない屋内の箇所を指定して,2D設計図面上の設計プレイヤーに修正を指示することになる。

また,2D設計図面上の設計プレイヤー側が,タッチ操作対応の液晶モニター上の2D設計図面で指差しすると,住人視点プレイヤーの視界にも指が現れる。

|

一連の作業は遠隔地同士でやるわけではないので,互いの指差しと肉声の会話を織り交ぜれば意思疎通は十分に行える。

Dollhouse VRがとてもユニークなのは,さらに,2D設計図面上の設計プレイヤーの上半身のリアルタイム撮影映像を,住人視点プレイヤーの視界にも表示しているところ。

これは音声だけよりは,2D設計図面上の設計プレイヤーの表情が見えたほうが意思疎通が図りやすい……という配慮からなのだが,住人視点プレイヤーからみると,なんだか巨人に見下ろされているような気分になって楽しげだ。

|

さて,このDollhouse VRシステム,単なる研究発表だけで終わらず,実際に試験運用も開始したそうである。具体的には,全国に店舗展開している「がんこフードサービス」の店舗内レイアウト検討に,このDollhouse VRシステムを実証実験的に活用したそうなのだ。研究グループによれば,この実証実験でいくつかの課題も見えてきたものの,設計とレビューの反復が迅速に行えることの手応えは得られたとのこと。

ちなみに,このDollhouse VR,システム全体の開発をゲームエンジンUnityで行っているそうで,最近,脚光を浴びつつある「ゲームエンジンのノンゲームユース」事例としても興味深い研究といえる。

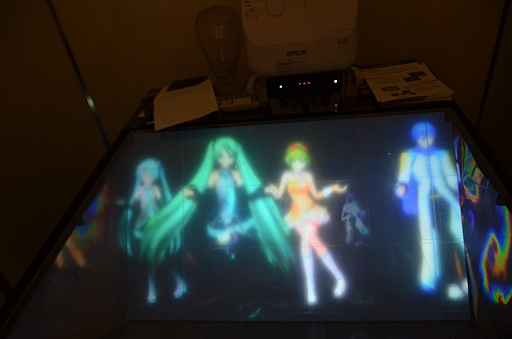

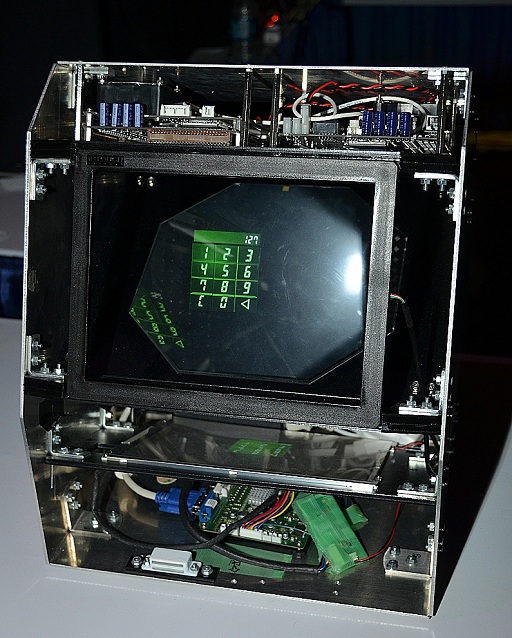

広視野角で低コストな空中結像ディスプレイ

R2D2 w/ AIRR

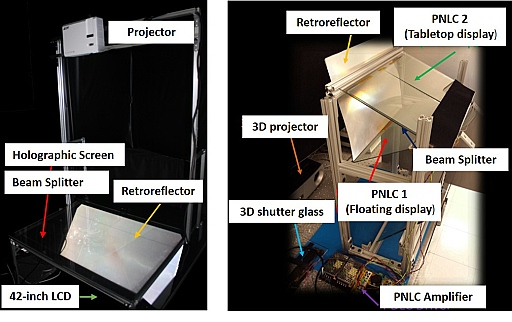

空中結像ディスプレイ技術は,すでに実用化も進んでいる技術テーマである。SIGGRAPHでも人気の研究テーマとなっており,毎年のように新しい技術が発表されているのだが,宇都宮大学 オプティクス教育研究センター / 工学部 情報工学科 / 大学院 工学研究科 先端光工学専攻 山本研究室が開発した「R2D2 w/ AIRR」も,この分野の新技術提案だ。

ちなみに,なにやらスターウォーズっぽい名前になっているが,正式技術名(発表論文名)は「Real time & Real space Double-Layered Display with Aerial Imaging by Retro-Reflection」で,その略記が「R2D2 w/ AIRR」となっている。

さて,現在の空中結像ディスプレイ技術は,筑波大学助教の落合陽一氏を中心とした研究グループが本家SIGGRAPH2015で発表していたような,空中の気体分子を画素として発光させるような大胆な技術(参考記事)もあるが,エネルギー効率や構造のシンプルさ,コストメリットの観点からは,実体としてのディスプレイパネル(液晶パネルなど)で表示した映像を,光学的な工夫で「観測者から見て空中にあるように見せる」という方式のほうが優位とされている。

|

今回発表された「R2D2 w/ AIRR」の仕組みは,後者に分類される技術で,とくにシンプルかつ低コストなのが特徴となっている。

同系の技術には,アスカネットが開発した「Aerial Imaging Plate」(以下,AI plate)があるが(参考記事),AI Plateは数百マイクロメートルの厚さの鏡面板と硝子板を直交させるように貼り合わせた二面直交リフレクター部材であり,アスカネットが独占製造販売している関係もあってコストは高めである。また,視野角も45°となっていて,まぁ広いとはいいがたい。

これに対し「R2D2 w/ AIRR」は,用いる光学部材は既存品であるため低コストで,視野角もAI Plateを上回る120°ほどを実現できているという。しかも,空間占有サイズ(実質的にシステムサイズ)はAI Plateと同程度というから,競争力も高いというわけだ。

山本研究室の山本裕紹准教授によると,R2D2 w/ AIRRでは「偽画像」が見えないこともAI Plateに対する優位点だと付け加えていた。AI Plateでは,仕様上の視野角を外れた角度から見ると,AI Plateの光路が作り出す「偽画像」が見えてしまう。R2D2 w/ AIRRにはこうした現象はないというわけだ。

|

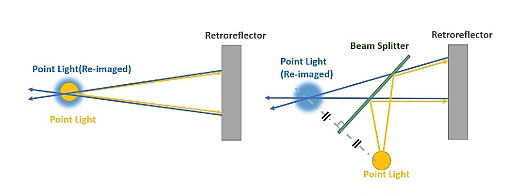

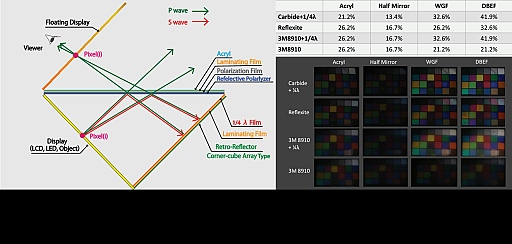

では,そのR2D2 w/ AIRRの光学的な構造はどうなっているのか。下図を見ながら解説していくことにしよう。

|

R2D2 w/ AIRRにおけるキーデバイスは二つある,一つは回帰性反射板(Retroreflector),もう一つはハーフミラー(Beam Splitter)だ。

回帰性反射板とは,入射光をその入射角で反射仕返す光学部材で,道路標識などに使われている(図の左側)。

ハーフミラーは,光の半分を反射して,半分を透過させる特性の光学部材なのだが,これを回帰性反射板と,図の右側のように配置させると,あら不思議,簡単に,空中結像させる(右図のRe-imagedの部分)ことができてしまうのだ。これがR2D2 w/ AIRRの基本原理となる。

ただし,ハーフミラーを用いるのは実は光利用率の面で芳しくない。というのもハーフミラーでは,映像パネルから出射した光を最初のハーフミラー到達時に半分透過させて捨ててしまうのだが,ここで反射した光も,回帰性反射板で反射して再びハーフミラーに到達したときには再び半分捨てることになってしまう。要は,空中結像させる表示映像がとても暗くなってしまうということだ。

そこで,R2D2 w/ AIRRでは,ハーフミラーの代わりに,反射偏光素子(Reflective Polarizer),偏光フィルム(Polarization Film),位相1/4回転系偏光フィルム(1/4 λ Film)を組み合わせることで,光の利用効率を上げている(下図)。

|

具体的にはR2D2 w/ AIRRでは,映像パネルから出射した光を最初に到達した反射偏光素子でP波(縦波:図中,緑矢印)とS波(横波:図中,赤矢印)と切り分けて,ここで半分のP波は捨ててしまうが(図中の飛び出しているP波),一方,回帰性反射板に導いた光(S波)は,位相1/4回転偏光素子の効果でP波になり二度目の反射偏光素子到達時には飛び出して(図中,目に向かっている緑矢印)捨てられずに観測者に向けて透過させるように仕向けている。

この効果により,ハーフミラー使用時の光利用率16.7%に対し,理論値50%に近い41.9%にまで引き上げられたとしているという。

|

|

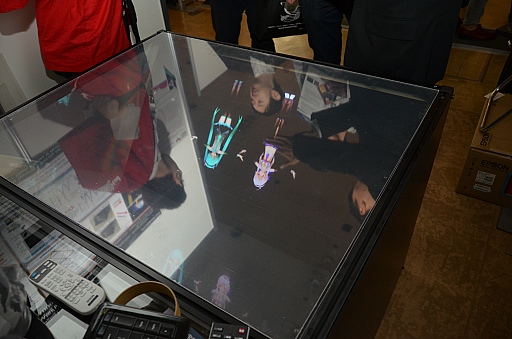

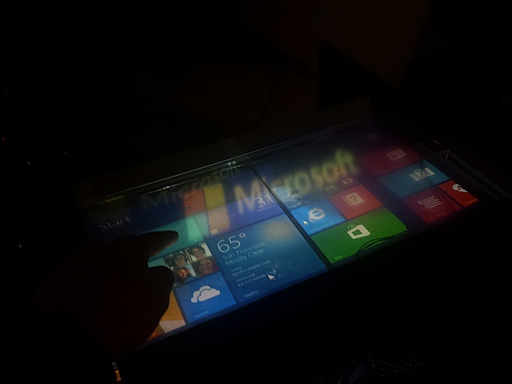

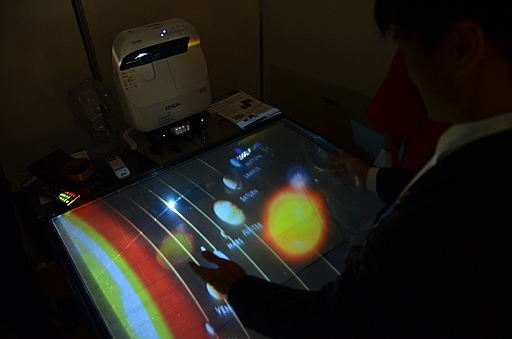

展示されていたR2D2 w/ AIRRでは,机上面に相当する反射偏光素子の部分をスクリーンに見立て,プロジェクタからの映像を投射させていた。

これにより,机上面にも映像が表示され,なおかつそこから浮き出たような映像表示効果が実現されるのだ。それこそ,基準面のデスクトップ画面からウィンドウやアイコンが観測者側に飛び出して見える……というなんともSFチックな視覚効果が得られるのである。

|

|

展示システムでは,マイクロソフトのKinectを用い,この空中結像映像のCGオブジェクトを両手を使ったモーション入力で操作できるデモも披露していた。

|

R2D2 w/ AIRRは,その広い視野角性能をうまく活用することで,博物館の展示で表示面の正面以外の人にも空中映像を見せられるなど,AI Plateとはまた違った応用が見出せるだろう。今後の応用展開にも注目していきたいものだ。

SIGGRAPH ASIA 2015関連記事

- この記事のURL: