ニュース

NVIDIAに追いつけ追い越せ? Intelが2024年以降のAI戦略を独自イベントで明らかに

|

というわけで,本稿では,Intel Vision 2024の内容を簡単にまとめてよう。

クラウドからエッジまで,自前のハードとソフトでカバーするIntel

IntelやAMDなど,プロセッサメーカーにとっての現在の課題は,AIにおけるNVIDIAの牙城を,いかにして崩していくかだ。これはAI分野にさほど興味がない人でも,ニュースで耳にしたことがあるだろう。Intel Vision 2024でIntelがアピールしているのも,そこに尽きるとまとめてしまっても構わないほどだ。

Intel Vision 2024で,同社が改めて強調しているのは,まずクラウド(データセンター)からエッジコンピューティングに至る幅広いセグメントで,スケーラブルなハードウェアを提供していくという点だ。クラウド向けから見ていくと,まず2024年にリリース予定のデータセンター向けAIアクセラレータ「Gaudi 3 AI Accelerator」(以下,Gaudi 3)が挙げられる。

|

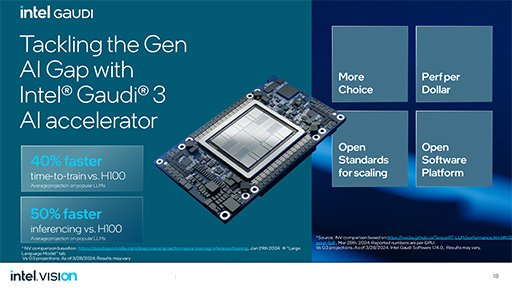

IntelのGaudiシリーズは,2019年に同社が買収したイスラエル企業Habana Labsが開発しているアクセラレータだ。現在は第2世代となる「Gaudi 2 AI Accelerator」が提供中だ。2024年に登場予定のGaudi 3は,AIで使用されている浮動小数点数「BF16」(bfloat16)形式の演算性能が,Gaudi 2の4倍ほど高速になっていて,NVIDIAの現行製品であるデータセンター向けGPU「H100 Tensor Core GPU」に対しても40%以上高速であると謳っている。

|

NVIDIAは2024年3月に,次世代アーキテクチャ「Blackwell」と,同アーキテクチャに基づく新型GPU「B200」を発表したばかりだ(関連記事)。ただ,NVIDIAのデータセンター向けGPUは,現行のHopperアーキテクチャ製品でも,オーダーから納品まで1年待ちといった状況が続いている。2024年後半予定のB200搭載製品が発売されても,入手できるのはかなり先になる可能性が高いだろう。

IntelのGaudi 3が,スライドに示されているとおりの実効性能を発揮できば,十分な競争力を持つと言えるのではなかろうか。

Intelによると,Gaudi 3は専用コネクタで接続する拡張カード(メザニンカード)タイプのほか,単独で利用できるベースボードタイプと,PCI Express(以下,PCIe)拡張カードという3種類のフォームファクタで登場するそうだ。これらのうち,IntelがとくにアピールしていたのはPCIeカード製品である。同カードを搭載したサーバー製品が,DellやHPE,Lenovo,Super Micro Computerといった主要サーバーメーカーから登場すると予告していた。

|

データセンター向けとしては,2024年にもうひとつ,第6世代Xeonプロセッサのリリースが控えている。第6世代Xeonプロセッサは,高性能寄りのP-coreだけを集積した開発コードネーム「Granite Rapids」と,電力性能を重視したE-coreだけを集積する開発コードネーム「Sierra Forest」という2種類が登場することが,以前から明らかにされていた。

今回,Intelは,開発者向けクラウドサービス「Intel Developer Cloud」において,Sierra Forestのインスタンスを2024年第2四半期に,またGranite Rapidsのインスタンスを2024年下半期に提供することを明らかにした。実製品のリリースも,そのあとで行われるということだろう。

|

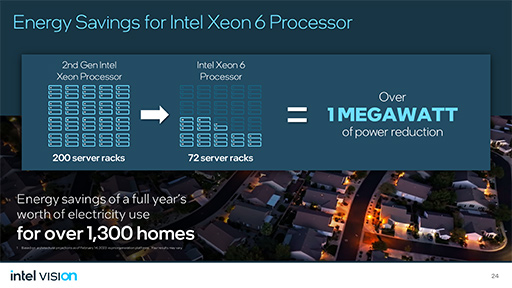

今回,Intelが力を入れてアピールしていたのは,先行するSierra Forestだ。第2世代Xeonにおいて200ラック分に相当する処理性能を,Sierra Forestならば72ラックで実現でき,実に1MWもの消費電力を削減できるとアピールしている。これは実に一般家庭1300軒分の消費電力に相当するそうだ。

|

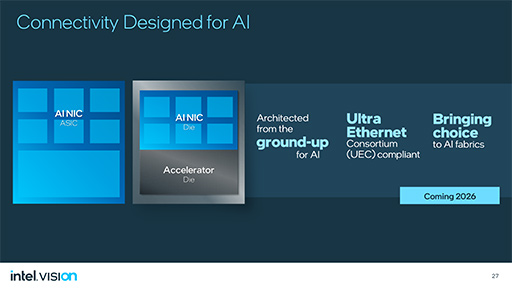

データセンター向けではもうひとつ,AI対応のネットワークインタフェース(AI NIC)を発売することを明らかにしている。新しいAI NICは,Ultra Ethernet Consortiumの規格に準拠した製品になるとのことだ。

|

Ultra Ethernet Consortiumとは,Linux Foundationが中心となって2023年に立ち上げた次世代イーサネット規格「Ultra Ethernet」の標準化団体である。これまでスーパーコンピュータやデータセンターで利用されてきた「InfiniBand」のような低遅延かつ広帯域の高速I/Oバスを,イーサネットをベースとしたオープンな技術で実現しようというものと,理解していいだろう。

AIにおいては,とくに学習を分散コンピューティングで高速化するために,次世代のネットワーク技術が必要とされているという。Intelがリリースを計画しているAI NICは,AIに最適化された機能と性能を持つものになるのだそうだ。

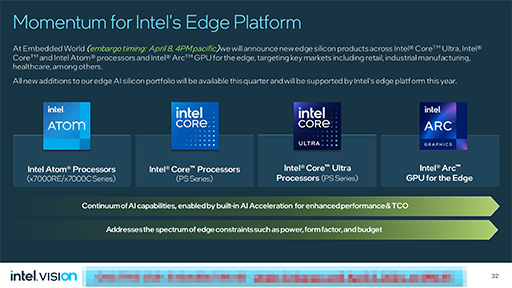

エッジコンピューティング向けのArc GPUが登場?

Intelは,データセンター向けだけでなく,クライアント側で処理するエッジコンピューティング向けにも,AI対応ハードを幅広く提供していくこともアピールしている。

Intelは,PC向けのCoreプロセッサやCore Ultraプロセッサ,組み込み機器向けの「Atom x7000」シリーズプロセッサなどでも,データセンター向けと互換性を持つAIのソフトウェア層を提供することで,高いスケーラビリティを実現するというのがIntelの主張だ。

少し目新しいのは,その中で「エッジ向けのArc GPUを発売する」と予告していた点だ。それ以上に詳しい話がなかったので,エッジ向けのArc GPUがどのようなものかは不明だが,AIに焦点を当てたアクセラレータを考えていることは間違いないようだ。Intelは,すでにCore Ultraプロセッサに搭載しているArc GPUコアを持っているので(関連記事),それをエッジ向けに流用していく,という話かもしれない。

|

ちなみにNVIDIAは,エッジ向けとして「Jetson」シリーズを提供しているが,この分野ではデータセンター向けGPUほどの成功を収めているとは言えない状況だ。また,NVIDIAはPC向けAI処理に関して,それほど重きを置いていなかったようにも思える。2023年には,GeForceシリーズを搭載したノートPCを「AI PC」と定義してアピールを始めたNVIDIAだが,それまではPCにおけるAIアプリケーションの活用をアピールしてきたとは言い難いからだ。

そのため,エッジコンピューティングのAIに関しては,NVIDIA以外の企業が付け入る隙が十分にあるのではなかろうか。

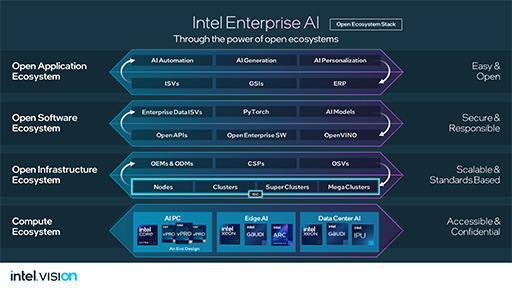

CUDAを利用しているAIの開発者はわずか5%?

さて,以上はハードウェア関連の話題だが,実際にはAIはソフトウェア技術であって,いくら優秀なハードウェアを取り揃えても,ソフトウェアが付いてこなければ普及は望めない。Intelは,エッジからクラウドまでオープンをキーワードに分厚いソフトウエア層の提供を約束し,それを持ってNVIDIAに対抗するとアピールしていた。

|

NVIDIAの強みはCUDAとよく言われるが,Intelの担当者は「CUDAを利用しているAIの開発者は5%ほどしかいない」と主張している。95%の開発者は,AI開発フレームワーク「PyTorch」のように,より高レベルなソフトウェア層で仕事をしているというわけだ。

これはたしかに一面の事実で,高レベルなソフトウェア層を自社製品に取り揃えることで,NVIDIAが擁するAIのエコシステムに対抗できる,というのがIntelのもくろみであるわけだ。

もっとも,「NVIDIAの強みはCUDA」と言うのも,あまり正確な主張とはいえないだろう。NVIDIAの強みは,「cuDNN」を始めとするCUDAを活用した分厚いソフトウェア層であって,CUDAだけではないからだ。NVIDIAが長年かけて育ててきた分厚いソフトウェア層に対抗するのは,どの企業にとっても容易なことではない。Intelによる挑戦の成否は,ソフトウェアエコシステムをいかにして育てるかにかかっている,と言えるのではないか。

Intel Vision 2024特設Webページ(英語)

- 関連タイトル:

Intel Arc(Intel Xe)

Intel Arc(Intel Xe)

- この記事のURL: