連載

【西川善司】AV誌に載らないCEATECネタ。遅延1フレーム未満のスキャンコンバータと,携帯電話でDirectX 11級グラフィックスのゲームを遊ぶ方法

西川善司 / グラフィックス技術と大画面とMAZDA RX-7を愛するジャーナリスト

|

(善)後不覚 |

|

アジア圏におけるコンピュータ関連展示会本流の座は,台湾で開催されるCOMPUTEX TAIPEIに奪われてしまった感が強いですが,家電に関するものではまだまだCEATECの存在が大きいという実感があります。

CEATECの主役は家電なので,4Gamer読者の関心は薄かったかもしれませんが,いくつかゲームに関連した展示もあったので,今回はそれらをピックアップしてみたいと思います。

マイコンソフト,表示遅延1フレーム未満の

「最速スキャンコンバータ」を発表

|

さて,そんなマイコンソフトがCEATECにブースを構えており,新作ハードウェアを展示していました。

発売されたばかりのSC-500N1/DVIも展示されていましたが,CEATECにおける目玉は,新作のスキャンコンバータ「FRAME MEISTER」(フレームマイスター)です。製品としては,いわゆるアップスキャンコンバータの部類に属するもので,D1〜D5ビデオ(D端子)やSビデオ,コンポジットビデオといったアナログビデオ映像,そしてアナログRGB映像(21ピン/15kHz)入力を,HDMI出力(最大1080p)に変換できます。

こうしたアップスキャンコンバータ製品は,他社からも発売されていますし,マイコンソフト自身もほぼ同機能を持った「XRGB-3」を出しています。では,わざわざコンセプトがカブる製品を出してくるのはなぜでしょう? 実のところFRAME MEISTERは「ゲーマー向けに特化した設計」がウリになっており,最大の特徴も,“超”低遅延性能になっているのです。

FRAME MEISTERの前面。左端は21ピンのアナログRGB入力に対応するコネクタだ。右端にはSビデオやコンポジットビデオ,アナログ2chサウンド入力などが並ぶ |

こちらは背面。左から順に,microSDスロット,HDMI出力,RCAによるアナログ2chサウンド入力,D入力,HDMI入力×2の端子が並んでいる。右端は制御用か |

ほとんどのアップスキャンコンバータ製品では,入力した映像を1度“溜め込んで”,それから処理を行って映像を出力する設計になっています。そのため,どうしても1フレーム以上の遅延が避けられません。しかしFRAME MEISTERでは,極めて低い遅延速度でアップスキャンを行って映像を出力します。入力された映像の解像度や種類(インターレース/プログレッシブ)などにもよりますが,ベストケースだと遅延は約1.3msになるそうです。一般的な60Hzの映像だと,1フレームあたり16.67msですから,表示遅延時間は0.07フレームという計算。「ワーストケースでも1フレーム以上遅延することはない」(マイコンソフト)だそうなので,おそらくアップスキャンコンバータ製品としては最低遅延を誇る製品となりそうです。

|

ちなみに映像プロセッサは,低遅延を最重要項目の1つとして開発されたというMarvellのデジタルビデオフォーマットコンバータ「88DE2750」が採用されているそうです。

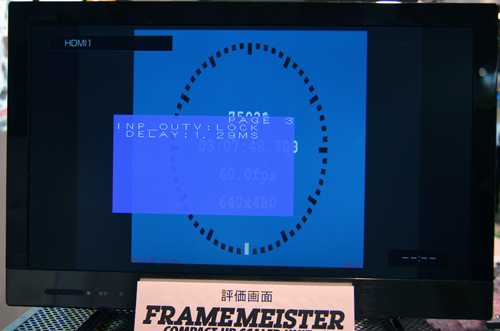

下に掲載した写真は実際にブースで撮影したもので,FRAME MEISTERとXRGB-3との表示遅延比較テストを行っている様子です。写真を見てもらえば分かると思いますが,FRAME MEISTERはXRGB-3よりも1フレーム高速でした。この差はゲーマーにとって心強いものだといえるでしょう。

「LCD Delay Checker」実行中の様子。上がFRAME MEISTER,下がXRGB-3だが,前者のほうが約1フレーム高速だ |

ネオジオ(MVS)「ラストリゾート」のデモ。FRAME MEISTERは,右の敵に発生している爆発エフェクトが先行している |

|

D端子入力にPSP用のモードが備わっているのも,スキャンコンバータとしてはユニークなポイントと言えるでしょう。PSPのテレビ出力機能には,テレビに出力されたゲーム画面が小さくなってしまうという制約があるのをご存じの読者も多いでしょうが,FRAME MEISTERなら,全画面表示になるよう,自動で調節してアップスキャン表示してくれます。

さらにこのFRAME MEISTERが心憎いのは,映像だけでなく音声もアナログ→デジタルへ変換してHDMI信号に乗せてくれるところです。FRAME MEISTERとHDMI入力を持つディスプレイ機器との間はHDMIケーブル1本で済むことになるわけですね。

また,将来のファームウェアアップデートで,背面のmicroSDカードスロットを利用したゲーム画面キャプチャ機能も搭載される予定とのとのことでした。これも楽しみな機能ですね。

2011年内の発売予定で,価格は未定とのことですが,見る限り,XRGB-3より高くなることはないと思います。

余談ですが,マイコンソフトのブースでは,同社が発売している各製品のワケアリ品(本体は新品だが,梱包箱が傷ついた商品など)を格安で販売してました。半額になっている製品も多数あったので,来年のCEATECはそれらを目当てに行くのもアリかもしれませんよ。

携帯電話でDirectX 11クラスのグラフィックスを

リアルタイムに表示する方法!?

望む望まないに関わらず,技術というのは上から下に降りてくるものですから,プログラマブルシェーダベースのグラフィックスパイプラインが携帯電話へ当たり前に載る時代は確実にやってくることでしょう。

しかし,「携帯電話に,そこまで高機能なグラフィックスレンダリング性能って必要なの?」という疑問は,どうしてもつきまといます。

GPUベンダーはすでに理論武装を完成させていて,たとえば「過剰なグラフィックス性能は,無駄にバッテリーを消費するだけだよ」と言うと,「おほほ。グラフィックスを使用していないときは3Dグラフィックスパイプラインの電源をオフにするから消費電力は最低限ざますよ」と確実に反論してきます。「『ほとんど使わない機能のためにGPUコアが高価になる』のはなんだか納得がいかない。GPUベンダーの本音としては,『高機能のプロセッサを高く売りたい』ということなんでしょ」と言った場合は,「そんなことはないざますよ。3Dゲームをやらない人でも,動画を見るために高性能なグラフィックス性能は必要ざましょ」なんて答えが返ってくることと思います(※まあ,動画再生のアクセラレーションだけなら,動画デコーダなどといった専用のロジックを搭載するほうが,トランジスタコストと消費電力の両面からリーズナブルだったりしますが)。

現実問題として,「携帯電話がマスのゲームプラットフォームになる」という未来像は現在進行形なので,彼らも全力でプッシュしてきています。「携帯電話で高度な3Dグラフィックスが本当に,まったく不要ですか? ああ゛?」と胸ぐらを掴まれたりすると,「必要な人には必要かも……」と弱々しい声で答えることになってしまうのではないでしょうか。

ゲームを制作する側の立場で考えてみると,携帯電話,とくにスマートフォンは,進化のスピードが速く,搭載されるGPUコアも驚くほどの速さで世代変わりしているため,そうしたプラットフォーム向けにゲームコンテンツを提供していくのはとても大変です。無数にある各携帯電話に対して個別にグラフィックスを調整するのは多大なコストがかかります。なので,「オレの端末だと,動くことは動くけど,動作が遅くて遊べないぜ」なんていうシチュエーションが実際に起こってきています。

そんなこともあってか最近では,発想を転換して,「携帯電話に向けた3Dグラフィックスのレンダリングは,クラウド側でやってしまうのはどうか」というアイデアが台頭してきていて,にわかに現実味を帯び始めています。

どういうことかというと,クラウド上でレンダリングされた高品位な3Dグラフィックスを,ネットワーク経由で携帯電話にストリーミング配信するというもの。携帯電話が行う処理は,「配信された動画を再生して表示する」だけというわけです。この仕組みを採用した場合,携帯電話側にハードウェアとしてのプログラマブルシェーダは必要なくなり,動画をデコードする機能だけあればよくなります。

「それってただのストリーミングムービーでは?」と思った人がいるかもしれません。でも,クラウドと接続している回線のスピードがちゃんとしていればゲームもできます。

たとえば,移動や攻撃などの各種アクションは,その操作だけを携帯電話側からクラウドへ伝送します。つまり,携帯電話側では,ゲームの入力系,操作系の処理プログラムだけを動かすのです。こうした処理はそこそこのCPU性能があれば事足ります。

そしてグラフィックスはもちろん,物理シミュレーションからAIなど,いわばゲームエンジンの本体はクラウド側で動作させることになります。

……と,ここまで説明すると,勘のいい人は「アレと同じか!」と思ったはずです。そう,最近NTTドコモのXi(クロッシィ)対応タブレット向けにサービスが始まった「ジークラウド」ですね。あるいは,英国でサービスインした「OnLive」を思い浮かべる人がいるかもしれません。

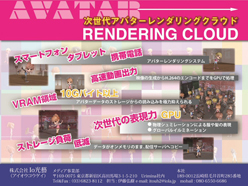

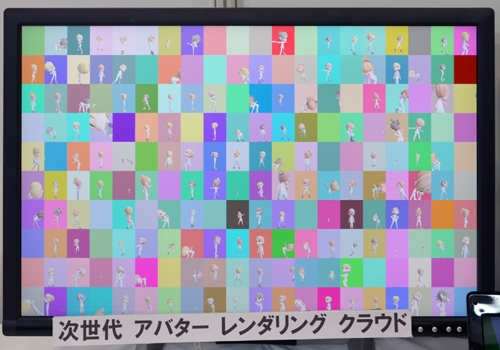

Io光藝ブース |

Io光藝では,自社製クラウドグラフィックスエンジンを用いて,リアルタイムで操作できる3DCGアバター提供サービスを現行携帯電話向けに提案している |

Io光藝のグラフィックスエンジンでは,大局照明や物理シミュレーションなどすべてを,DirectX 11クラスのGPUで行います。そしてそのレンダリングされた映像をH.264形式でリアルタイムエンコードし,携帯電話にストリーミング配信します。

これにより携帯電話の画面でDirectX 11クラスの3Dグラフィックスが楽しめるというわけです。

ただ,携帯電話の画面解像度が低いので,クラウド側のGPU 1基を1台の携帯電話に割り当てるのはなんだかオーパースペックです。

そこで,Io光藝のグラフィックスエンジンは,1基のGPUで複数ユーザー分の3Dグラフィックスをレンダリングする設計になっています。

面白いのは,オンラインゲームなどにおいて,同一シーンで複数のユーザーが参加しているような状況では,DirectX 10世代以降に搭載された新機能であるマルチビューポート機能を用いて,単一GPUで一気に複数視点分の(複数ユーザー分)のレンダリングを行うことができる点です。

|

ちなみに,現在主流の移動通信システムである3Gネットワークは,伝送速度がいまひとつなのはもちろんのこと,なによりも遅延が大きいため,ゲームのようなリアルタイムのクラウドサービスを利用するのに適しているとは言い難いです。

しかし,LTEなどに代表される4G移動体通信システムでは,そうした遅延問題が劇的に改善されると言われています。先述のとおり,ジークラウドはXi(および無線LAN)ネットワーク向けのサービスですしね。

新世代ネットワークが普及し切るよりも,携帯電話にプログラマブルシェーダがあまねく搭載される時代のほうが先に来そうな気はしなくもないですが,いずれにせよ,4Gネットワークが普及した世界では,そうしたクラウドベースのゲームエンジンやグラフィックスエンジンの利用が積極的に行われることでしょう。

|

でも,携帯電話でのプレイ中,トンネルに入ったりして回線が落ちて操作不能でゲームオーバーになったりするのはストレスが溜まるかな。

| ■■西川善司■■ テクニカルジャーナリスト。4Gamerの連載「3Dゲームエクスタシー」をはじめ,オンライン/オフラインのさまざまなメディアに寄稿したり,バカゲーを好んでプレイしたり,大画面にときめいたり,観切れないほどBlu-rayビデオを買ったり,オヤジギャグを炸裂させたりして毎日を過ごしている。 |

- この記事のURL: